您的位置:主页 > 公司动态 > 每日行情 > 每日行情

靠近人类,OpenAI新版GPT-4o三连炸-香港期货开户

“GPT-4o的稀奇之处,在于它将GPT-4级其余智能带给了所有人,包罗我们的免用度户。”

北京时间5月13日破晓,早有预告的OpenAI春季更新准期而至。

在这次总时长不到半个小时的宣布会中,圈内最熟悉的公司首席执行官山姆 奥特曼(Sam Altman)并未现身,首席手艺官穆里 穆拉蒂(Muri Murati)及两名研究主管马克 陈(Mark Chen)和巴雷特 佐夫(Barret Zoph)三人围坐,配合先容了这次更新:

推出桌面版ChatGPT & 网页端UI更新,以及最主要的,宣布GPT-4o。

其中的“o”代表“omni”,意为万能的。凭证OpenAI官网给出的先容,GPT-4o可以处置文本、音频和图像随便组互助的输入,并天生对应的随便组合输出。稀奇是音频,它可以在短至232毫秒的时间内响应用户的语音输入,平均320毫秒的用时已经靠近人类在一样平常对话中的反映时间。

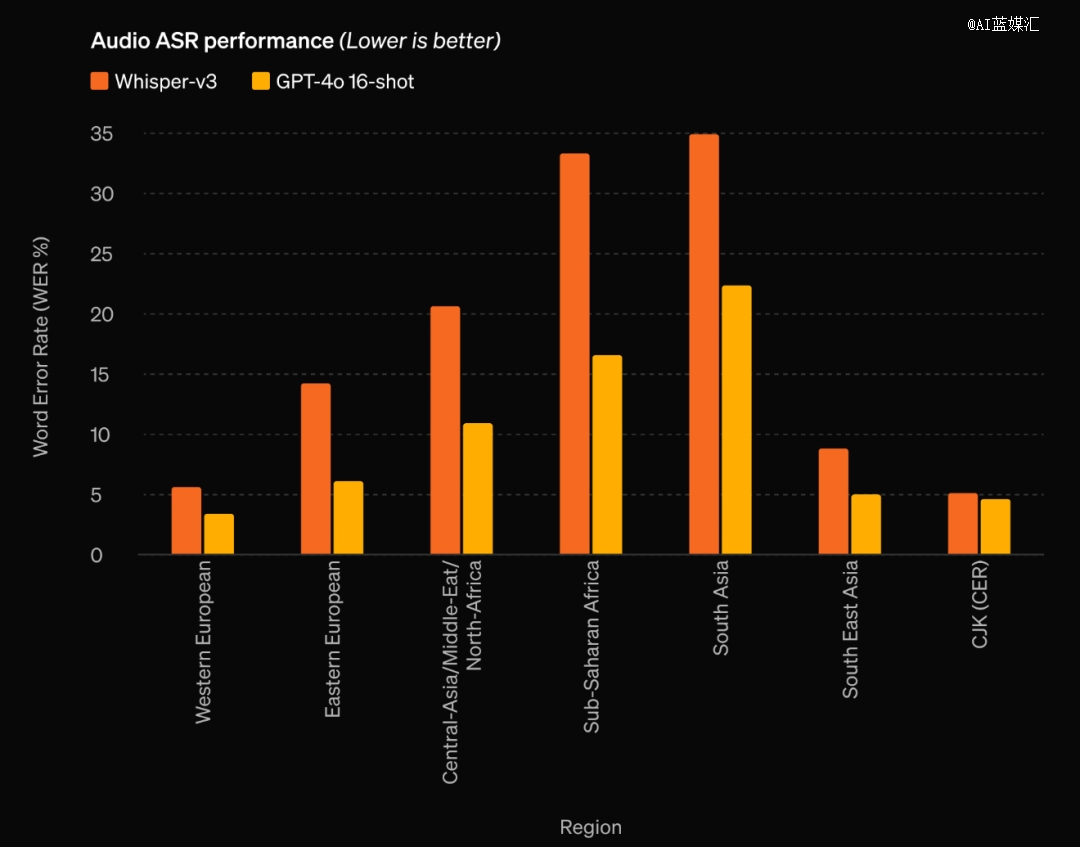

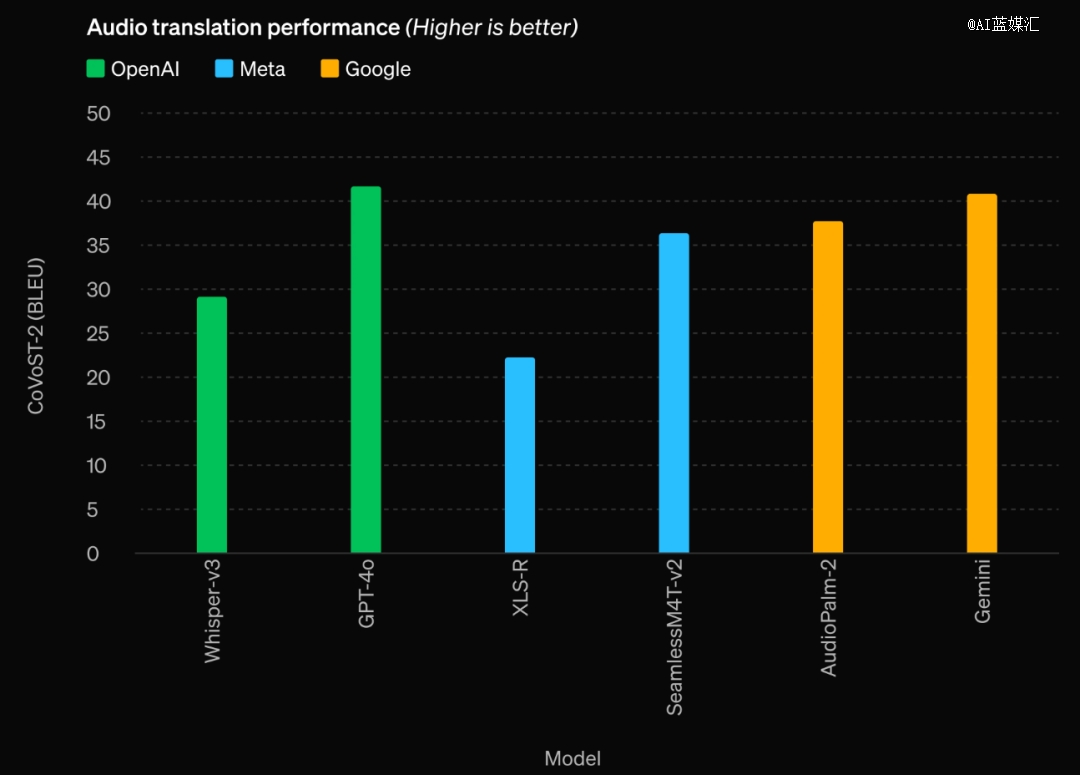

与现有模子相比,GPT-4o在视觉和音频明白方面尤其精彩。

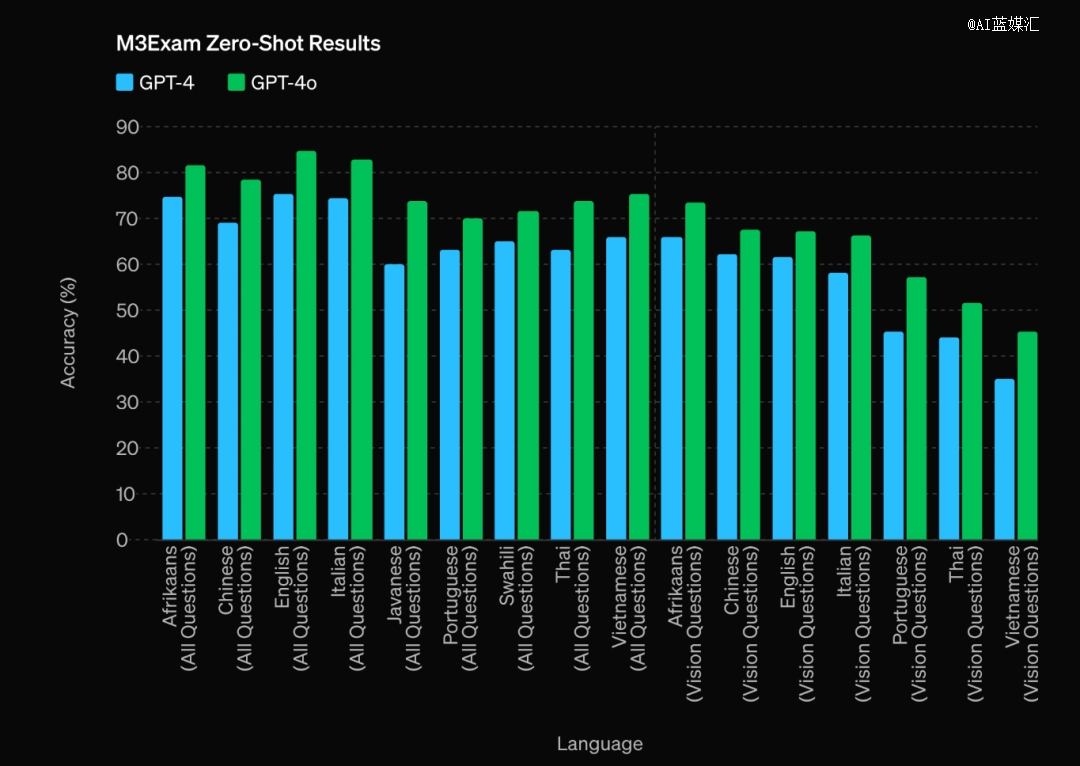

此外,GPT-4o在英语文本和代码上的性能也与GPT-4 Turbo处于统一水平线,在非英语文本上的性能有着显着提高,同时API速率快,速率限制凌驾5倍,成本则降低了50%。

穆里 穆拉蒂示意,OpenAI使命的一个异常主要的部门,是让他们的高级人工智能工具能够向所有人免费提供,让人们对手艺的能力有“直观的感受”。

要害词:更快,更强,还免费。

固然,现在官方给出的免费限制在一定的新闻数目上,跨越这个新闻量后,免用度户的模子将被切换回ChatGPT,也就是GPT3.5,而付用度户则将拥有五倍的GPT-4o新闻量上限。

现实上,早在去年九月末,OpenAI团队就已在官网宣布过一片文章,先容那时的ChatGPT的语音对话和看图识图功效。

在此前加入播客节目“All-in Podcast”时,山姆 奥特曼曾谈及了ChatGPT的多模态交互能力,以及对包罗GPT-5在内新一代AI产物更新的态度。

对于ChatGPT已有的语音功效,播客主持人示意他和家人很喜欢这个功效,只管应用时不时还会泛起一些延迟问题。

奥特曼那时回应称,OpenAI会继续改善并提升语音功效的质量:“我信托,语音交互是通向未来交互方式的一个主要线索。若是能够实现真正优质的语音互动体验,将会是一种与盘算机互动的全新方式。”

对于响应速率不够快、对话缺乏流通度和不自然的感受,奥特曼示意团队正起劲改善,致力力于让这些方面的体验获得显著提升。

现在,就像他本人在X平台上的预告,新宣布的GPT-4o“像邪术一样”。

在此前的模子中,用户使用语音模式与ChatGPT对话的平均延迟为2.8秒(GPT-3.5)和5.4秒(GPT-4)。造成延迟的缘故原由是:语音模式是由三个自力模子组成的通道,*个简朴模子将音频转录为文本,GPT-3.5或GPT-4吸收并输出文本,第三个简朴模子再将该文本转换回音频。

投资界24h| OpenAI震撼弹:新模型语音水平接近人类;一级市场去库存:打三折都没人要;险资发起100亿银发基金

这个转录再转回的历程,导致GPT-4丢失了其中的大量信息,无法直接考察音调、多个语言者(的音色区别)或靠山噪音,也无法输出笑声、讴歌或表达情绪。

而借助GPT-4o,OpenAI跨文本、视觉和音频,端到端地训练了一个新模子。所有输入和输出都在该模子中交由统一神经网络举行处置。

因此,新宣布的GPT-4o模子,可以做到随时最先或打断对话,识别语言人的语气、情绪,凭证场景或指令天生多种音调、带有厚实人类情绪特征的音频回复(甚至可以要求GPT-4o唱歌)。

图像处置层面,在传统意义上识图的基础上,GPT-4o可以识别手写体(如解答手写的方程组)、精准剖析数据,并能够读懂画面中人物的面部神色。

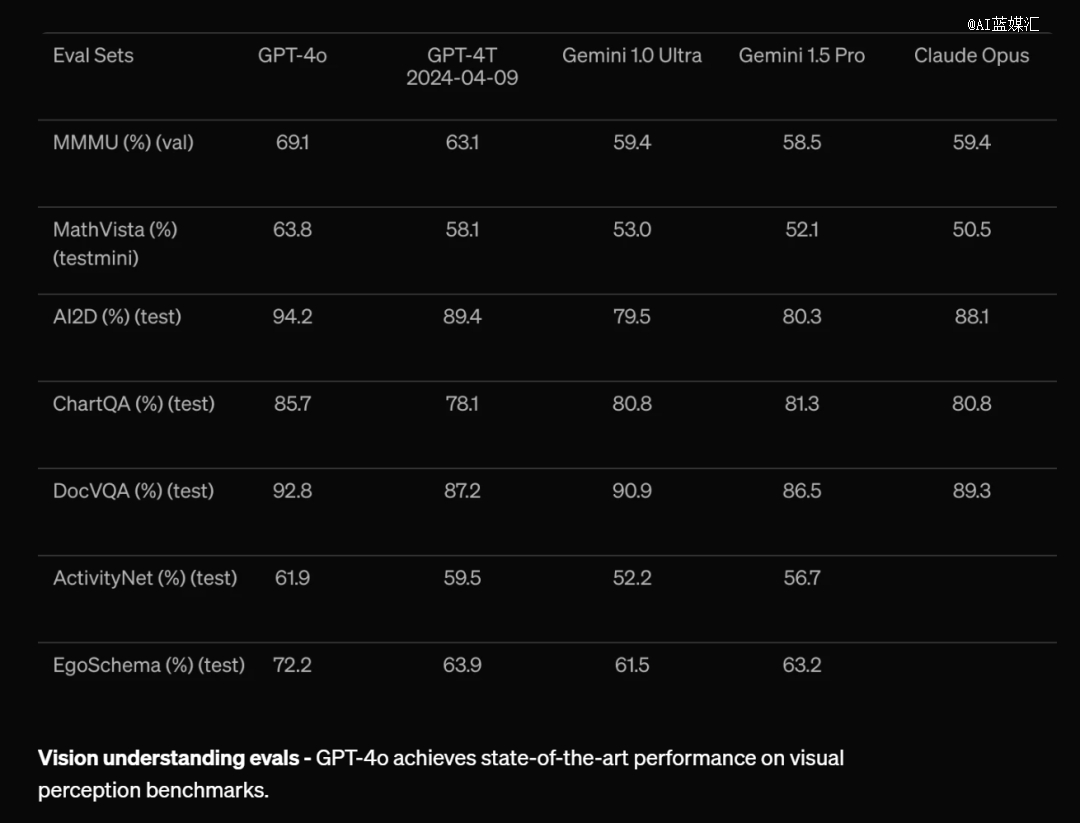

数据层面,凭证传统基准测试,GPT-4o的性能对比GPT-4 Turbo基本都处于优势,对比其他模子更是大幅*。

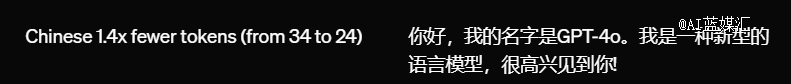

凭证官网给出的资料,现在GPT-4o已经支持包罗中文在内的20种语言举行音频等多模态交互。OpenAI示意,这次更新“是朝着适用性的偏向生长”,此次宣布会主要聚焦于免用度户,新功效将在未来几周内逐步推送给所有用户。

多模态交互的上限再次被拉高,OpenAI仍是谁人拥有*明白,总能先一步给出范式的玩家。

接下来要期待的,或许是*个在宣布会上打出“对标GPT-4o”的大模子厂商,会何时泛起了。事实,这生怕不只是改个PPT的事儿。

会是明天的谷歌吗?